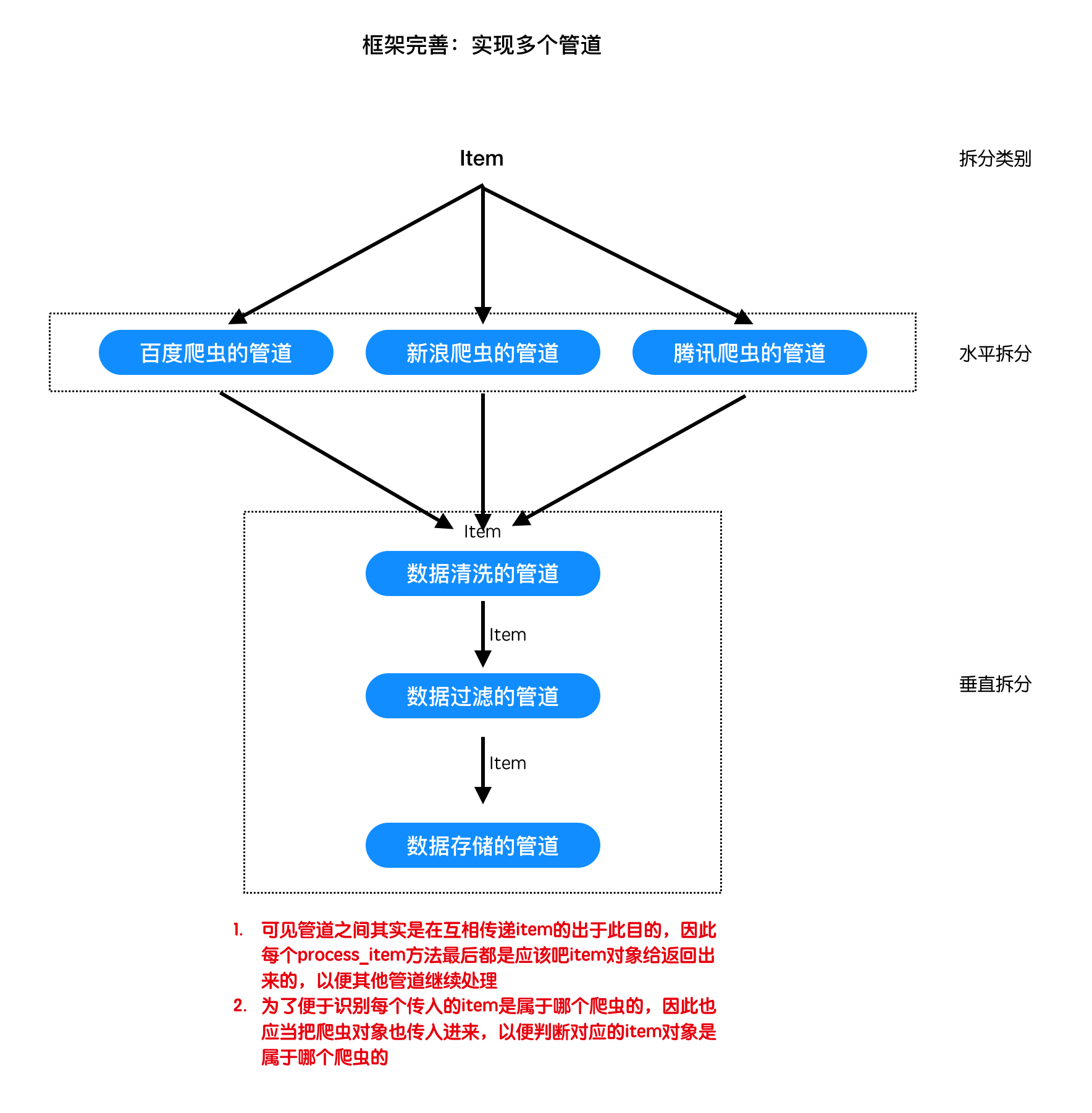

# 3.6. 框架完善--实现多个管道

# 目标

- 实现对引擎的修改,达到数据通过多个管道的目的

# 1. 为什么需要多个管道

同爬虫文件一样,不同的爬虫可能需要不同的管道文件,因此管道文件需要在项目中进行实现

# 2. 项目文件夹中实现管道文件

在项目文件夹下建立pipelines.py文件,不同在于:

- 这里的process_item必须把item对象最后再返回回来,因为是多个管道文件的设置了

- 需要增加一个参数,也就是传入爬虫对象,以此来判断当前item是属于那个爬虫对象的

# project_dir/pipelines.py

from spiders.baidu import BaiduSpider

from spiders.douban import DoubanSpider

class BaiduPipeline(object):

# 这里有所不同的是,需要增加一个参数,也就是传入爬虫对象

# 以此来判断当前item是属于那个爬虫对象的

def process_item(self, item, spider):

'''处理item'''

if isinstance(spider, BaiduSpider):

print("百度爬虫的数据:", item.data)

return item # 最后必须返回item

class DoubanPipeline(object):

# 这里有所不同的是,需要增加一个参数,也就是传入爬虫对象

# 以此来判断当前item是属于那个爬虫对象的

def process_item(self, item, spider):

'''处理item'''

if isinstance(spider, DoubanSpider):

print("豆瓣爬虫的数据:", item.data)

return item # 最后必须返回item

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

# 3. 修改引擎的代码

- 管道对象将从外部传入

- 调用管道的process_item方法时,需要遍历出管道

- 并且需要传递第二个参数,爬虫对象

# scrapy_plus/core/engine.py

......

class Engine:

'''完成对引擎模块的封装'''

def __init__(self,spiders,pipelines=[]):

'''

实例化其他的组件,在引起中能够通过调用组件的方法实现功能

'''

# self.spider = Spider()

self.spiders = spiders

self.downloader = Downloader()

self.pipelines = pipelines

self.scheduler = Scheduler()

self.spider_mid = SpiderMiddleware()

self.downloader_mid = DownloaderMiddleware()

self.total_request_nums = 0

self.total_response_nums = 0

def start(self):

'''

提供引擎启动的入口

:return:

'''

start_time = datetime.now()

logger.info("爬虫启动:{}".format(start_time))

self._start_engine()

end_time = datetime.now()

logger.info("爬虫结束:{}".format(start_time))

logger.info("爬虫一共运行:{}秒".format((end_time-start_time).total_seconds()))

logger.info("总的请求数量:{}".format(self.total_request_nums))

logger.info("总的响应数量:{}".format(self.total_response_nums))

def _start_request(self):

for spider_name,spider in self.spiders.items():

for start_request in spider.start_requests():

#1. 对start_request进过爬虫中间件进行处理

start_request = self.spider_mid.process_request(start_request)

start_request.spider_name = spider_name

#2. 调用调度器的add_request方法,添加request对象到调度器中

self.scheduler.add_request(start_request)

#请求数+1

self.total_request_nums += 1

def _execute_request_response_item(self):

#3. 调用调度器的get_request方法,获取request对象

request = self.scheduler.get_request()

if request is None: #如果没有获取到请求对象,直接返回

return

#request对象经过下载器中间件的process_request进行处理

request = self.downloader_mid.process_request(request)

#4. 调用下载器的get_response方法,获取响应

response = self.downloader.get_response(request)

response.meta = request.meta

#response对象经过下载器中间件的process_response进行处理

response = self.downloader_mid.process_response(response)

#response对象经过下爬虫中间件的process_response进行处理

response = self.spider_mid.process_response(response)

#parse方法

spider = self.spiders[request.spider_name]

parse = getattr(spider,request.parse)

#5. 调用爬虫的parse方法,处理响应

for result in parse(response):

#6.判断结果的类型,如果是request,重新调用调度器的add_request方法

if isinstance(result,Request):

#在解析函数得到request对象之后,使用process_request进行处理

result = self.spider_mid.process_request(result)

result.spider_name = request.spider_name

self.scheduler.add_request(result)

self.total_request_nums += 1

#7如果不是,调用pipeline的process_item方法处理结果

else:

for pipeline in self.pipelines:

result = pipeline.process_item(result,spider)

self.total_response_nums += 1

......

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

65

66

67

68

69

70

71

72

73

74

75

76

77

78

79

80

81

82

83

84

85

86

87

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

65

66

67

68

69

70

71

72

73

74

75

76

77

78

79

80

81

82

83

84

85

86

87

# 4.修改main.py

为引擎传入项目中的管道对象:

# project_dir/main.py

from scrapy_plus.core.engine import Engine # 导入引擎

from spiders.baidu import BaiduSpider

from spiders.douban import DoubanSpider

from pipeline import BaiduPipeline, DoubanPipeline

if __name__ == '__main__':

baidu_spider = BaiduSpider() # 实例化爬虫对象

douban_spider = DoubanSpider() # 实例化爬虫对象

spiders = {BaiduSpider.name: baidu_spider, DoubanSpider.name: douban_spider} # 爬虫们

pipelines = [BaiduPipeline(), DoubanPipeline()] # 管道们

engine = Engine(spiders, pipelines=pipelines) # 传入爬虫对象

engine.start() # 启动引擎

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

2

3

4

5

6

7

8

9

10

11

12

13

14

15

# 小结

- 本小结重点

- 完成代码的重构,实现多个管道的效果