# 1.2. 爬虫的分类和爬虫的流程

# 目标

- 掌握爬虫的分类

- 掌握爬虫的流程

- 了解搜索引擎的知识

- 了解robots协议

# 1. 爬虫的分类

在上一小结中,我们介绍爬虫爬取到的数据用途的时候,给大家举了两个例子,其实就是两种不同类型的爬虫

根据被爬网站的数量的不同,我们把爬虫分为:

- 通用爬虫 :通常指搜索引擎的爬虫

- 聚焦爬虫 :针对特定网站的爬虫

# 2.爬虫的流程

请思考:如果自己要实现一个和百度新闻一样的网站需要怎么做?

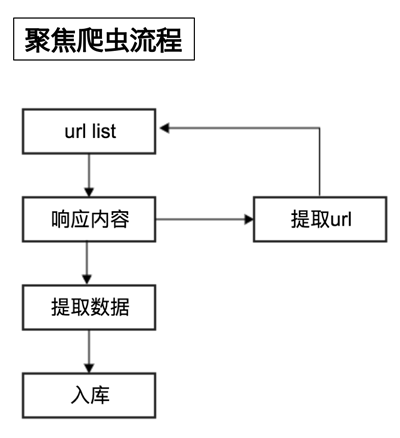

# 2.1 聚焦爬虫的工作流程如下:

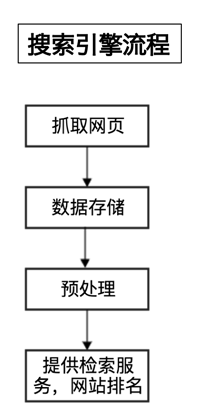

# 2.2 搜索引擎的工作流程如下:

但是搜索引擎类似的通用爬虫的工作流程有些不同

# 2.3 搜索引擎的局限性

- 通用搜索引擎所返回的网页里90%的内容无用。

- 图片、音频、视频多媒体的内容通用搜索引擎无能为力

- 不同用户搜索的目的不全相同,但是返回内容相同

# 3. robots协议

Robots协议:网站通过Robots协议告诉搜索引擎哪些页面可以抓取,哪些页面不能抓取,但它仅仅是道德层面上的约束

例如:淘宝的robots协议 (opens new window)

# 小结

- 本小结重点

- 爬虫的分类

- 爬虫的流程

- robots协议的理解